【详述】

按照官网案例 flinkcdc 实时读取mysql 写入starRocks,任务启动不报错,但是数据没写入starRocks

【导入/导出方式】

mysql 利用StarRocks-migrate-tools 实时导入 starRocks

【StarRocks版本】1.17

【flink版本】1.13.6

【集群规模】例如:2fe(1 follower+2observer)+4be(fe与be混部)

【机器信息】CPU虚拟核/内存/网卡,例如:16C/32G/万兆

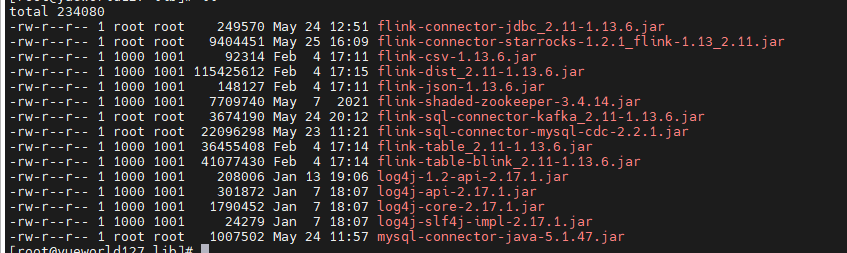

flink jar:

StarRocks-migrate-tools 生成的脚本:

config_prod.conf (3.0 KB) starrocks-create.1.sql (500 字节) flink-create.1.sql (1.4 KB)