为了更快的定位您的问题,请提供以下信息,谢谢

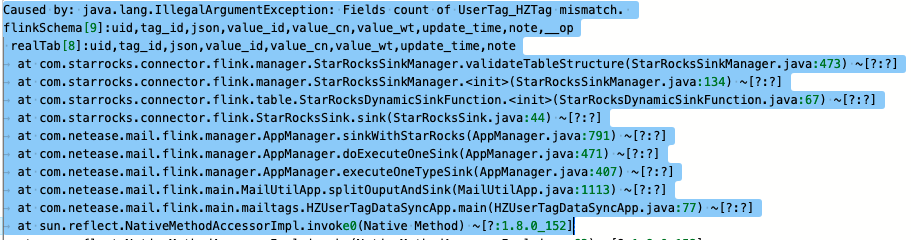

【详述】一个PrimaryKey 表,通过flink connector写入数据时提示__op字段不能为空的异常,同样的程序,写入AGGREGATE Key聚合表是正常的。查阅资料后,这个__op字段应该是用于主键记录的写入模式设置的,但不知道flink connector中如何简单地对其默认值进行设置,尝试过在flink程序内部逻辑增加写入字段,以及设置sink.properties.columns='xxxx,__op=0’均无法成功。

【业务影响】

数据无法正常写入主键表记录,只能写入聚合表

【是否存算分离】

否

【StarRocks版本】1.25.2,flink connector 1.2.1_flink-1.11_2.12

【集群规模】例如:3fe(1 follower+2observer)+3be(fe与be混部)

【表模型】主键模型

【导入或者导出方式】例如:Flink+flink connector ,stream load

【联系方式】vincent_hxk@163.com, 18620237249

【附件】

- 完整的报错异常栈

2024-03-27 13:07:07,212 INFO com.starrocks.connector.flink.manager.StarRocksStreamLoadVisitor [] - Stream load properties: {“row_delimiter”:"\x02",“format”:“csv”,“max_filter_ratio”:“0.01”,“strip_outer_array”:“true”,“column_separator”:"\x01"}

Wed, Mar 27 2024 1:07:07 pm2024-03-27 13:07:07,413 WARN com.starrocks.connector.flink.manager.StarRocksSinkManager [] - Failed to flush batch data to StarRocks, retry times = 1

Wed, Mar 27 2024 1:07:07 pmcom.starrocks.connector.flink.manager.StarRocksStreamLoadFailedException: Failed to flush data to StarRocks, Error response:

Wed, Mar 27 2024 1:07:07 pm{“Status”:“Fail”,“BeginTxnTimeMs”:0,“Message”:“too many filtered rows”,“NumberUnselectedRows”:0,“CommitAndPublishTimeMs”:0,“Label”:“4d83cb45-f752-4f09-b175-13333c93462c”,“LoadBytes”:7996912,“StreamLoadPlanTimeMs”:0,“NumberTotalRows”:64000,“WriteDataTimeMs”:187,“TxnId”:24938117,“LoadTimeMs”:188,“ErrorURL”:“http://xxxx/api/_load_error_log?file=error_log_7840fd8f0626b090_32c91687f5d658aa",“ReadDataTimeMs”:2,“NumberLoadedRows”:0,"NumberFilteredRows”:64000}

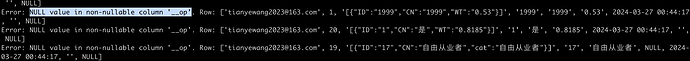

{“streamLoadErrorLog”:"Error: NULL value in non-nullable column ‘__op’. Row: [‘snswc2@163.com’, 17, ‘[{“ID”:“1”,“CN”:“是”,“WT”:“0.6090”}]’, ‘1’, ‘是’, ‘0.6090’, 2024-03-27 13:06:52, ‘’, NULL]\n